e prosegui la navigazione supportata dalla pubblicità

senza pubblicità

Per inviarci segnalazioni, foto e video puoi contattarci su info@moto.it

La sala è piena, il tono è serio, a tratti allarmato. La conferenza ha fatto emergere una consapevolezza che ormai attraversa tutto l’ecosistema informativo: la rivoluzione dell’AI non ha soltanto accelerato la produzione di contenuti, l’ha resa esponenziale, automatica, indistinguibile. E questo, per chi ogni giorno tenta di fare giornalismo, significa una cosa sola: il terreno su cui camminiamo è sempre più friabile.

I ricercatori (Virginia Padovese, Giuseppe Scuotri e Valeria Zuccoli) hanno aperto con un dato che, per quanto noto, continua a colpire: la disinformazione è oggi al primo posto nella lista dei rischi globali del World Economic Forum. Non terrorismo, non crisi energetiche, non catastrofi naturali: disinformazione. Il paradosso è che non riguarda più solo apparati propagandistici o gruppi criminali: la disinformazione siamo anche noi.

Basta condividere un link senza verificarlo, basta una caption scritta male, basta fidarsi del “l'ho letto da qualche parte”. La definizione che arriva dal palco è semplice:

Nel primo caso, potenzialmente, siamo tutti colpevoli.

Il cuore dell’incontro arriva quando i relatori mostrano come l’intelligenza artificiale sia diventata l’arma perfetta per chi vuole manipolare il discorso pubblico. Fino a pochi anni fa, creare un sito di notizie false richiedeva tempo, soldi e competenze tecniche. Oggi basta:

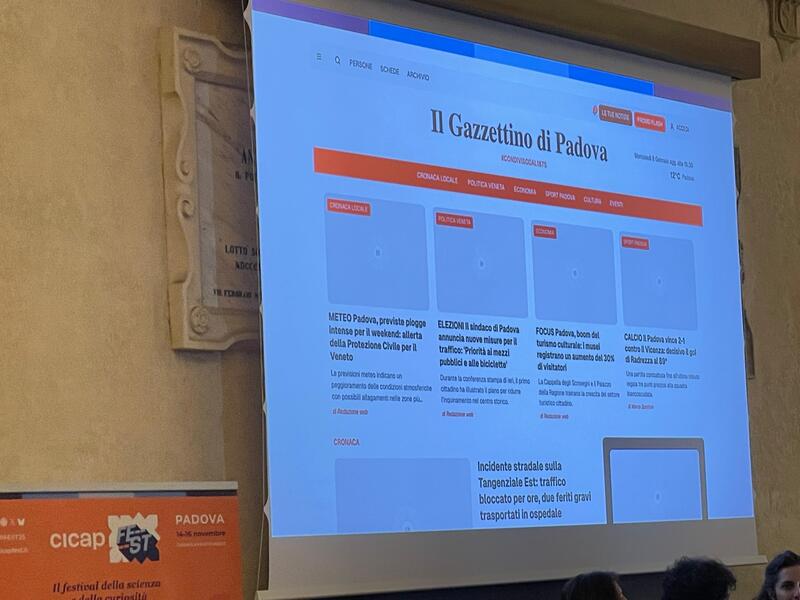

Sembra una provocazione, ma non lo è: sul palco viene mostrato un sito di news locali completamente inventato, fabbricato da zero durante una serata tra ricercatori. Impaginazione professionale, notizie verosimili, immagini generate da modelli grafici: un finto quotidiano locale studiato per sembrare reale. E quello era un gioco. Nel mondo reale, invece, esistono già network da centinaia di siti che imitano testate americane o europee, tutti gestiti da singoli propagandisti, spesso dall’estero, con finalità politiche chiare e un arsenale di strumenti automatici.

La parte più inquietante non è la creazione del contenuto falso in sé, ma è la tecnica che lo rende credibile: pubblicare articoli accurati al 98%, inserendo al loro interno solo un piccolo frammento di informazione falsa. Un metodo sottile, studiato per superare il controllo dell’utente medio: se tutto l’articolo è corretto, perché mettere in dubbio quella singola frase? È disinformazione chirurgica: si infiltra perché sembra normale.

Tuttavia, la parte peggiore è dedicata a un fenomeno allarmante: la disinformazione creata con l’AI viene rimessa online, poi gli stessi sistemi di AI la "leggono", la assorbono e la restituiscono come possibile verità.

Cosa significa questo? Al giorno d'oggi, ognuno di noi - anche inconsciamente - utilizza l'IA per velocizzare le proprie ricerche e, come ben saprete, quest'ultima vi fornisce una risposta in base alle informazioni disponibili sul web. Se le informazioni sono "corrotte", l'intelligenza artificiale non è capace di distinguere cosa sia giusto o meno, ma si basa solo ed esclusivamente in base alle notizie più diffuse, probabilmente corrotte dalla notizia che ha generato più traffico. Insomma, sembra essere un cortocircuito perfetto.

I ricercatori l’hanno misurato: testando dieci chatbot in lingue diverse e, nel 35% dei casi, le intelligenze artificiali hanno riprodotto la fake news come se fosse un fatto storico reale (più del doppio rispetto all’anno precedente). E non serve un grande pubblico: molti dei siti che diffondono queste narrative hanno pochissimi follower. Ma non servono persone, servono algoritmi che si addestrano. È sufficiente che la bugia sia da qualche parte nel web.

Ed è qui che entra in gioco il vero nodo per chi fa informazione. Il giornalista non è soltanto chiamato a verificare i fatti: oggi deve anche correre contro il tempo. Perché una fake news, una volta diffusa, vive più a lungo della smentita.

Gli studiosi del cognitivismo lo chiamano “illusione della verità”: la prima informazione che recepiamo, anche se falsa, resta più impressa della correzione successiva. È una battaglia impari: un contenuto generato in otto secondi può richiedere otto ore di verifiche, telefonate, incroci di fonti, consultazioni. Il pubblico, nel frattempo, ha già letto, condiviso, ingoiato e metabolizzato la versione sbagliata. E l’AI peggiora il quadro: i lettori si abituano a chiedere a un assistente digitale “che cosa è successo?”, ottenendo come unica risposta un contenuto potenzialmente inquinato. Nessun link, nessuna gerarchia delle fonti, nessun processo di selezione. Solo una verità preconfezionata.

La ricetta proposta sul palco ha due ingredienti:

Per ora, la regolamentazione europea c’è, ma è ancora timida. La tecnologia corre più veloce delle leggi, e la disinformazione sfrutta ogni varco. L'incontro del CICAP Fest non ha offerto soluzioni miracolose. Ha però chiarito una cosa: siamo entrati in un territorio nuovo, dove la comunicazione non è più soltanto un flusso di notizie, ma una battaglia per la sopravvivenza della realtà.

Fare giornalismo, oggi, significa muoversi in un ambiente in cui ogni informazione può essere contraffatta, ogni immagine può essere sintetizzata, ogni fonte può essere imitata. E dove la prima versione - vera o falsa che sia - continua a valere più della successiva correzione. Un mondo in cui l’AI può essere un alleato, ma anche un moltiplicatore di caos. E in cui compito del giornalista non è mai stato così necessario (e così fragile).